QUELLES SONT LES CONSÉQUENCES DU FUTUR RÈGLEMENT IA POUR LES ENTREPRISES ?

22 déc. 2023

L’IA va entrainer de nombreux bouleversements et une nouvelle génération de produits et de services. L'accord provisoire du Conseil et du Parlement européen du 9 décembre 2023, sur la future réglementation régulant l'intelligence artificielle va fournir des conditions d'exercice pour un développement responsable et innovant des systèmes. Le point sur cette première législation au monde sur l'IA.

Les conséquences du futur Règlement sur l’intelligence artificielle suite à l'accord politique du Parlement européen et du Conseil, le 9 décembre 2023, seront importantes.

Les entreprises qui utilisent des systèmes de décision automatisée devront évaluer les risques et rendre transparent la manière dont les systèmes fonctionnent et les données qui sont utilisées pour les entraîner.

Les entreprises disposant des systèmes sur la biométrie devront garantir par exemple, la non discrimination ou ne pas évaluer ou créer des notations sur les comportements ou étudier de manière approfondies des caractéristiques personnelles. Les entreprises dotées de systèmes d’IA devront également informer très clairement sur les données utilisées et conséquences de l'utilisation du dispositif. Cependant, le texte prévoit de nouveaux bacs à sable pour tester des innovations dans un environnement maîtrisé pour assurer l’innovation en toute conformité et la durabilité des solutions.

Assurer un cadre responsable de l’IA

“Certains de ces modèles [IA] pourraient présenter des risques systémiques, car ils sont très performants ou largement utilisés” alerte la Commission européenne. Ainsi, il apparaît nécessaire pour l’Europe nécessaire d’encadrer la puissance de l’IA et d’assurer un cadre éthique protégeant les individus et droits fondamentaux.

Ce texte a pour ambition de devenir une norme internationale a l’image du RGPD qui porte la vision européenne et inspirée de nombreux pays. Il est articulé en cohérence avec la protection des données, la protection des consommateurs et les textes de lutte contre les discriminations. Il est à relever dans le texte que la conformité au règlement IA ne constituera pas “un fondement juridique pour le traitement des données à caractère personnel, y compris des catégories spéciales de données à caractère personnel, le cas échéant”.

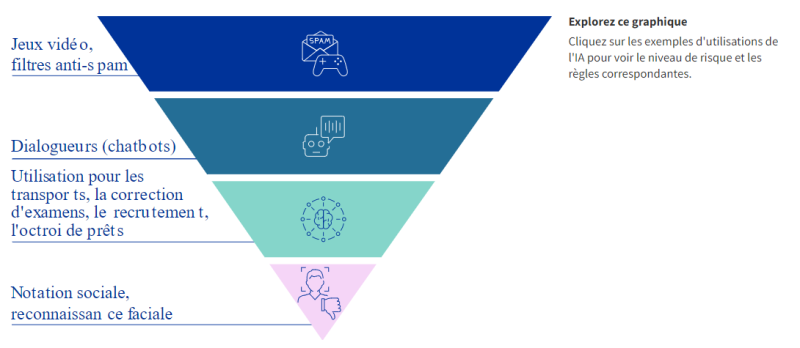

Une approche fondée sur l’analyse de risque

Ainsi, la future législation vise à canaliser l'IA et sa “capacité de porter préjudice à la société, l'idée est principalement de réglementer celle-ci selon une approche fondée sur les risques, à savoir : plus le risque est élevé, plus les règles sont strictes. Cela est déjà le cas pour le RGPD, la cybersécurité ou plusieurs directives ou règlements du secteur financier.

Cependant sous réserve d’intérêt public et de limitations et de pseudonymisation ou cryptage, l’utilisation de données sensible sera autorisée “dans la mesure où cela est strictement nécessaire aux fins de la surveillance, de la détection et de la correction des biais en ce qui concerne les systèmes d’IA à haut risque”.

Ce texte ne s’appliquerait pas aux systèmes militaires, à la recherche et innovation et aux solutions à usages non professionnelles. Grandes ou petites entreprises seront soumises et tenues de démontrer que leurs systèmes d’IA sont conformes aux nouvelles exigences.

Quatre types de risques liés à l’utilisation de l’IA sont identifiés

La réglementation prévoit quatre catégories de risques : inacceptable, élevé, limité, minime ou nul.

Les systèmes interdits

Les systèmes à risque inacceptable sont par exemple ceux qui visent des évaluations sociales, l’incitation à des comportements dangereux par des dispositifs d’interaction ou encore des techniques subliminales au-dessous du seuil de conscience d'une personne pour altérer substantiellement son comportement et de manière à causer un préjudice physique ou psychologique ou systèmes d'identification biométrique à distance "en temps réel" dans des espaces accessibles au public à des fins répressives (sauf certaines exceptions)

Les IA à risques élevés

Les systèmes à risque élevé sont généralement ceux relatifs aux secteurs critiques ou d’importance vitale.

Ce sont par exemple, les technologies d'IA des transports susceptibles de mettre en danger la vie et la santé des citoyens; les technologies d'IA utilisées dans l'éducation ou l’emploi, les technologies utilisées dans les composants de sécurité des produits, les services privés et publics essentiels tels que l'évaluation du risque de crédit, les technologies d'IA utilisées dans le domaine du maintien de l'ordre, les technologies d'IA utilisées dans le domaine de la gestion de la migration, de l'asile et des contrôles aux frontières (par exemple, la vérification de l'authenticité des documents de voyage), les technologies d'IA utilisées dans les domaines de l'administration de la justice et des processus démocratiques …

Risque limité

Les systèmes à risque limité sont les chatbots ou outils d'aide à la décision.

Les solutions à risque minime sont par exemple, les jeux vidéo compatibles avec l'IA ou des filtres anti-spam.

Un durcissement et une transparence accrue

Par exemple, pour les systèmes à haut risques, les entreprises devront fournir l'identité et les coordonnées du fournisseur et, le cas échéant, de son mandataire; les caractéristiques, les capacités et les limites de performance du système d’IA à haut risque, notamment : sa destination, le niveau d’exactitude, de robustesse et de cybersécurité visé à qui a servi de référence pour les tests et la validation du système d’IA à haut risque et qui peut être attendu, ainsi que toutes circonstances connues et prévisibles susceptibles d’avoir une incidence sur le niveau attendu d’exactitude, de robustesse et de cybersécurité…

Les systèmes d'IA ne présentant qu'un risque limité seraient soumis à des obligations de transparence très peu contraignantes, par exemple celle consistant à faire savoir que le contenu a été généré par l'IA, de façon à ce que les utilisateurs puissent prendre des décisions éclairées sur la poursuite de leur utilisation.

Création d’un bureau européen sur l’IA et une autorité de marché

Un bureau de l'IA est créé au sein de la Commission pour superviser ces modèles d'IA parmi les plus avancés et pour contribuer à promouvoir normes et pratiques d'évaluation et faire appliquer les règles communes dans tous les États membres. Un groupe scientifique d'experts indépendants conseillera le Bureau de l'IA.

Le Comité de l'IA, qui compterait des représentants des États membres, restera en place pour servir de plateforme de coordination et d'organe consultatif de la Commission et conférera un rôle important aux États membres pour la mise en œuvre du règlement, y compris l'élaboration de codes de bonnes pratiques pour les modèles de référence. Enfin, un forum consultatif destiné aux parties prenantes, telles que les représentants de l'industrie, les PME, les jeunes pousses, la société civile et le monde universitaire, sera mis en place afin de fournir une expertise technique au Comité de l'IA.

Les sanctions

En cas de non respect des sanctions allant jusqu'à 35 millions d'euros ou 7% du CA pourront être prononcées pour des applications interdites.

15 millions d'euros ou à 3 % pour les violations des obligations découlant de la législation sur l'IA et à 7,5 millions d'euros ou à 1,5 % pour la communication d'informations inexactes. L'accord prévoit des plafonds plus proportionnés pour les amendes administratives infligées aux PME et aux jeunes pousses en cas d'infraction aux dispositions de la législation sur l'IA.

L'accord de compromis précise également qu'une personne physique ou morale peut déposer une réclamation pour non-respect de la législation sur l'IA auprès de l'autorité de surveillance du marché compétente.

Garantir la résilience

Pour garantir un niveau de cybersécurité adapté aux risques, le texte impose des mesures appropriées devraient donc être prises par les fournisseurs de systèmes d’IA à haut risque, en tenant également compte, si nécessaire, de l’infrastructure TIC sous-jacente aux systèmes.

Transparence et responsabilité

La loi sur l'IA impose également la transparence et la responsabilité des systèmes d'IA. Les entreprises qui utilisent des systèmes d'IA devront être transparentes sur la manière dont ces systèmes fonctionnent et sur la manière dont ils traitent les données personnelles.

Le texte change la manière dont les entreprises communiquent avec leurs clients et utilisateurs sur leurs pratiques d'IA. Par exemple, les entreprises devront expliquer de quelles manières les systèmes d'IA sont utilisés à leurs clients, ou fournir des informations sur la manière dont ces systèmes prennent des décisions.

Innovation

La loi sur l'IA prévoit également des mesures de soutien à l'innovation. Ces mesures visent à stimuler le développement d'une IA sûre et responsable.” La loi sur l'IA permet en outre la création de bacs à sable réglementaires et de tests dans le monde réel, aideront à créer les conditions-cadres appropriées permettant aux entreprises de développer et de déployer l'IA avec des bacs à sables réglementaires. "Des centres d'excellence en IA offriront un environnement contrôlé pour tester des technologies innovantes pendant une durée limitée, favorisant ainsi l'innovation des entreprises, des PME et des start-ups dans le respect de la loi sur l'IA”.

Les entreprises qui utilisent l'IA doivent commencer à se préparer dès aux changements qui seront apportés par ce texte. Il pourra s'appliquer deux ans après son entrée en vigueur, une fois le texte approuvé par les co législateurs.

Les principales modifications importantes apportés par cet accord provisoire sont les suivantes :

-

Instauration de règles sur les modèles d'IA à finalité générale et à fort impact susceptibles de créer un risque systémique à l'avenir ainsi qu'aux systèmes d'IA à haut risque

-

Révision du système de gouvernance, doté de certains pouvoirs d'exécution au niveau de l'UE

-

Elargissement des interdictions, s'accompagnant toutefois de la possibilité, pour les autorités répressives, d'utiliser l'identification biométrique à distance dans les espaces publics, sous réserve de garanties

-

Obligation pour les opérateurs de systèmes d'IA à haut risque de procéder à une analyse d'impact sur les droits fondamentaux avant de mettre un système d'IA en service.

Pour en savoir plus : https://www.consilium.europa.eu/fr/press/press-releases/2023/12/09/artificial-intelligence-act-council-and-parliament-strike-a-deal-on-the-first-worldwide-rules-for-ai/

Patrice REMEUR pour Prorisk Cyber